Blog

Retour aux articlesDark patterns, biais cognitifs et deep fake : comment lutter ?

Partager

Catégories

Dark patterns, biais cognitifs et deep fake : comment lutter ?

Vendredi prochain, je participerai à une table ronde organisée par la DGCCRF sur le thème des biais cognitifs et des dark patterns : une occasion de faire le point sur ce sujet hautement inflammable à une heure où la sortie de Gemini 3 et de Nano Banana Pro rendent encore plus facile la falsification de l’information. Dans cet article, je vous fais un petit point sur les différents types de dark pattern que peuvent rencontrer les consommateurs et les pièges et les arnaques qui vont débarquer sur nos écrans à cause des progrès de l’IA.

A l’origine des arnaques digitales, nos biais cognitifs

Les biais cognitifs sont un sujet en vogue depuis quelques années, et tout ceux qui travaillent dans le digital en ont entendu parler au moins une fois. Ce qu’on appelle biais cognitifs, je me permets de vous en donner ma définition très personnelle, sont tous les moyens d’exploiter le fonctionnement normal de notre cerveau à ses limites, c’est à dire dans des cas de figures où celui-ci n’interpréte pas correctement l’information qu’il reçoit, car elle est biaisée.

L’image le plus simple pour comprendre un biais cognitif est de se rappeler ce qu’est une illusion d’optique : c’est typiquement l’exploitation d’une fonctionnalité de notre cerveau, la vue, en en abusant. On vous fait voir quelque chose que votre cerveau interprète comme il le peut résultant en la vision de quelque chose qui n’existe pas.

Ces limites du cerveau sont utilisées en permanence, parfois pour nous guider, nous éduquer, nous améliorer. On appelle ça des nudges. Dans le cas contraire, quand ces limites sont utilisées pour nous inciter à faire des actions qui nous nuisent, on appelle cela un dark pattern.

La liste des dark patterns est longue et exploitée depuis longtemps dans le marketing pour tenter d’améliorer la performance commerciale des dispositifs numériques, ces techniques allant parfois jusqu’à la malhonnêteté tout en restant dans la légalité, d’où la grande difficulté pour ceux qui écrivent les lois de fixer la limite entre ce qui relève de la pure mauvaise intention à la tentative d’escroquerie avérée.

Voici quelques exemples simples :

- Utilisations de couleurs inversées : le vert pour le rouge par exemple

- Positionnement de boutons inversés : le bouton “Valider” conventionnellement placé à droite de l’interface est placé à gauche, etc

- Diminution de la taille d’un bouton pour le rendre difficile à trouver ou à cliquer : c’est une pratique que l’on va trouver sur de nombreuses publicités

- Lien d’annulation d’abonnement diminué et mis en bas de page

- Publicité déguisée qui ont l’air de contenus naturels, mais n’en sont pas

D’autres ressorts peuvent encore être utilisés, comme ce qu’on pourrait appeler de la manipulation mentale :

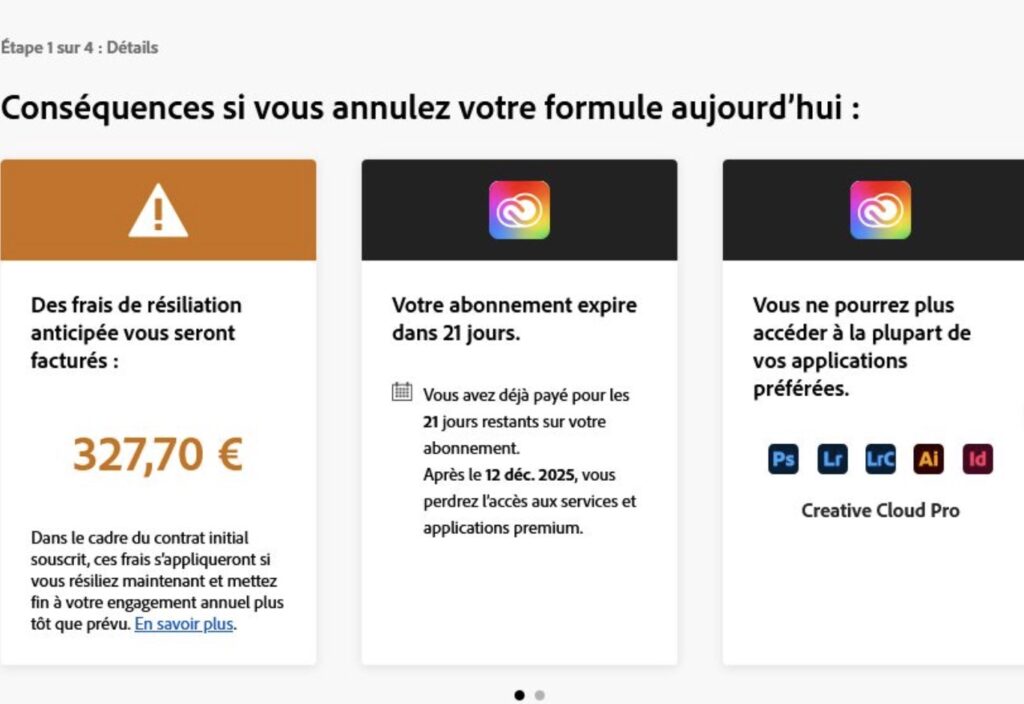

- Jouer sur la peur de manquer, la honte, sur la sollicitation du sentiment de rareté ou d’urgence, par des mécanismes interactifs basés sur des fausses données, parier sur le découragement à exécuter une action en rendant, par exemple, particulièrement difficile le désabonnement à un service (Roach Motel).

Tous ces dark patterns n’exploitent pas forcément nos biais cognitifs et peuvent s’appuyer sur d’autres ressorts.

La continuité forcée est une technique courante de prolongation forcée d’un abonnement gratuit en le passant en abonnement payant après avoir prélevé les informations bancaires de l’utilisateur. Le site marchand compte sur l’oubli de l’utilisateur pour lui faire payer un service dont il n’a pas besoin.

Assez courant, mais maladroit : le forçage de produit au panier. C’est le cas courant des assurances ajoutées à la dernière minute semblant obligatoires, mais qui ne le sont pas. Technique hautement prohibée.

Coûts cachés : cette technique consiste à ajouter des frais de dossiers à la fin d’une commande, ayant demandé beaucoup d’interaction et d’engamenent de l’utilisateur. C’est une exploitation du biais d’engagement qui vous fait continuer quelque chose, parce que vous y avez mis beaucoup d’efforts et ne voulez pas perdre cet engagement.

L’IA générative : nouvelle menace

Avec la démocratisation des IA génératives et leur mise à disposition à un large public, de nouvelles opportunités “créatives” s’offrent aux fraudeurs de toutes sortes. La catalogue est impressionnant tant les possibilités sont diverses et variée, et surtout faciles à mettre en œuvre. Il ne faut vraiment plus beaucoup de talent pour devenir un “trompeur” patenté et les arnaques vont se multiplier dans les prochains mois, sans qu’il soit facile de lutter ni de réglementer.

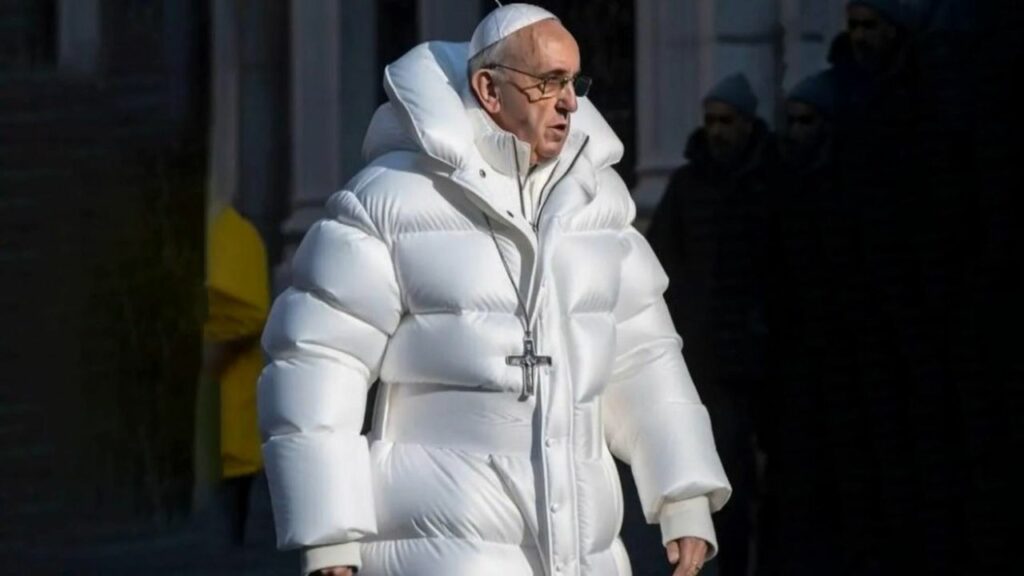

Avec des outils comme Veo 3 ou Sora, créer des vidéos de personnes réelles, célèbres ou pas, est aussi simple que de faire un prompt. Nano Banana ou ChatGPT peuvent faire de même pour ce qui concerne les images.

Voici ce que j’ai trouvé qui peut montrer l’étendue des possibilités.

Récemment, Tibo in Shape s’est retrouvé pris au piège de ses fans quand ceux-ci se sont mis à diffuser des vidéos parodiques utilisant l’image du Youtubeur qui leur avait donné l’autorisation de le faire. Si l’histoire était sympathique au départ, l’expérience a vite mal tourné, certains faisant tenir des propos racistes ou insultants à Tibo in Shape.

Les choses peuvent aller très loin et sont très faciles à réaliser, comme on peut le voir dans l’exemple ci-dessous. Tous ces trucs et ces bonnes pratiques se propagent à une vitesse fulgurante et tombent rapidement entre de mauvaises mains.

J’ai demandé à Gemini de me lister quelques unes de ces techniques et vous allez voir qu’elles vont très loin.

L’usurpation d’autorité : ici, c’est le biais d’autorité qui est exploité. Des arnaqueurs utilisent des vidéos réelles de personne célèbre, et grâce à des technologies de lipsyncing leur font dire autre chose que ce qu’ils dient. Ils peuvent par exemple recommander un produit ou une offre. Leur célébrité sert alors de caution au service.

Le faux témoignage client (User Generated Content – UGC) : technique encore plus abordable. Il s’agit de créer des témoignages clients en vidéo qui expriment leur satisfaction d’un produit ou d’un service. Seul souci, la personne n’existe pas et a entièrement été générée avec de l’IA. Des outils comme Synthesia ou Heygen se prêtent fort bien à la création de ces vidéos. Ici, c’est le biais de la preuve sociale qui est exploité.

Le produit fantôme : sans doute encore plus facile avec la nouvelle version de Nano Banana. Là, il s’agit simplement de vendre un produit qui n’existe pas en le créant de toute pièces avec l’IA. Images superbes, mises en ambiance, gros plans ultraléchés sur les détails, etc… rien n’arrête l’IA pour aider à créer toutes sortes d’images et même de vidéos… Là encore, le travail à fournir est ridicule en regard du retour sur investissement. La suite de l’arnaque consiste simplement à envoyer un produit qui a peu à voir avec le produit présenté, ou tout simplement, c’est encore mieux, de ne pas l’envoyer. C’est l’effet de halo qui est utilisé dans ce cas.

La fausse rareté visuelle : comme je vous le disais, il n’y a pas de limites à l’IA, sauf l’imagination de leurs utilisateurs. Dans ce cas, l’idée est simplement de créer des images de foule devant un magasin ou un entrepôt. Il ne reste plus qu’à faire circuler pour susciter l’envie par cette preuve totalement artificielle.

Bien que la vidéo et l’image soient en vogue, la génération pure de texte par IA peut aussi être exploitée pour tromper les consommateurs. Une technique courante sont les faux avis massifs qui peuvent être générés par des scripts automatisés. Des centaines d’avis peuvent être déposés sur un produit : l’IA peut faire facilement varier le nom des personnes déposant l’avis, leur ton, leur orthographe, etc. Cette technique exploite les plateformes peu exigeantes avec le contrôle des avis. Ici, c’est le biais de conformité qui est exploité : beaucoup de personnes aiment un produit, c’est donc la preuve que c’est un bon produit.

Les outils utilisés

On a vu émerger des centaines d’outils digitaux qui utilisent l’IA générative. J’ai demandé à Gemini de me dire quels étaient les plus utilisés.

- HeyGen / Synthesia :

- Usage légitime : Créer des vidéos de formation ou de marketing avec des avatars virtuels pour éviter de payer des acteurs et du matériel de tournage.

- Détournement : Création de faux clients (UGC – User Generated Content) qui racontent une histoire larmoyante ou enthousiaste sur un produit frauduleux. On peut choisir l’âge, l’ethnie et l’accent pour cibler parfaitement la victime.

- Wav2Lip (et dérivés) :

- Usage technique : Synchroniser les lèvres d’une vidéo existante avec une nouvelle piste audio.

- Détournement : C’est la technologie de base des Deepfakes. On prend une vidéo d’un présentateur de JT célèbre (ex: Élise Lucet ou David Pujadas) et on modifie le mouvement de leurs lèvres pour leur faire dire qu’une nouvelle application financière est “révolutionnaire

- ElevenLabs :

- Usage légitime : Doublage de vidéos, lecture de livres audio, accessibilité pour les muets.

- Détournement : C’est l’outil de référence actuel pour les arnaques. Il suffit de quelques secondes d’un extrait audio (récupéré sur YouTube ou TikTok) pour cloner la voix de n’importe qui (célébrité ou proche). Utilisé pour les fausses recommandations (ex: la voix d’Elon Musk qui vend de la crypto)

- Midjourney (v6) :

- Usage légitime : Art conceptuel, design, illustration.

- Détournement : C’est actuellement le plus performant pour le photoréalisme. Il est utilisé pour générer des photos de produits qui n’existent pas (dropshipping), des fausses photos “avant/après” (régime, chirurgie), ou des images de célébrités utilisant le produit.

- DALL-E 3 (via ChatGPT) :

- Usage légitime : Illustration rapide.

- Détournement : Moins réaliste que Midjourney pour les humains, mais très fort pour créer de faux documents, de fausses captures d’écran de comptes bancaires bien garnis, ou de faux certificats de garantie pour rassurer la victime.

Comme Gemini est modeste, il a oublié de citer Nano Banana Pro qui est sans doute l’outil le plus avancé en la matière.

- ChatGPT (OpenAI) / Claude / Llama :

- Usage légitime : Rédaction, aide au code, synthèse.

- Détournement :

- Fermes à avis : “Écris-moi 50 avis positifs pour ce produit, avec des styles différents, certains courts, certains longs, et inclus quelques fautes d’orthographe pour faire vrai.”

- Sniping : Générer des emails de phishing ou des pages de vente hautement persuasifs en utilisant les principes de Cialdini (les 6 principes de l’influence) de manière industrielle.

Allez, je termine sur une petite note d’humour avec Vincent Flibustier qui montre qu’on peut vraiment faire n’importe quoi avec l’IA.